这是一个创建于 661 天前的主题,其中的信息可能已经有所发展或是发生改变。

最近想用 qwen 来协助开发,但感觉总是答非所问,还给人一种懒惰不肯干活的感觉

研究了一下,发现我用的是 qwen-turbo ,单价 0.008 元,而通义千问又提供了 0.12 元的 qwen-max ,切换之后,效果果然棒棒的,唯一缺点就是价格高了,有些贵

再想起各位吐槽国产大模型,我在想是不是因为目前客户端提供的都是菜鸡 qwen-turbo ,而真正高能力的大模型没有被普遍大众体验到,所以导致有种错觉国产不如 GPT4 ?

理性探讨,不要带有情绪,谢绝一切情绪发泄

免责声明,不为 qwen 或者任何其他国产大模型站台,只是开源项目想探讨一下 AI 编程的可行性而已

1

JeriffCheng 2024 年 4 月 23 日 via iPhone 国内几乎所有的大模型都是在 llama 的基础上用中文语料二次训练 finetune 出来的, llama 是 facebook 公司搞出来的。集合中国境内所有的显卡都不够从 0 训练出一个大模型,这是算力限制。二次训练就会出现各种后遗症,答非所问,中英文混搭,这种现象在提供给普通用户的几个 G 的小体积裁剪模型文件里尤其严重,大体积几十 G 的模型文件要好很多,但是普通家用显卡没有那么大的显存来运行大体积模型文件,所以只能部署在企业的服务器上,以云服务按 token 计费的方式来提供给普通用户使用。

|

2

JeriffCheng 2024 年 4 月 23 日 via iPhone 严格意义上说,并不存在所谓的国产大模型,因为全都是 fine-tune 人家的模型,只是在毛坯房的基础上刷了一层漆,全世界无数人每天都在刷漆,甚至拿几块 4090 花半个月时间也能浅浅的刷一遍漆。如果英语水平稍微好一点,直接使用联网 Chatgpt 的话,效果比千问这些要好的多的,中文语料的缺失可以通过联网搜索解决,你让它以中文回答就好了。

|

3

sighforever 2024 年 4 月 23 日 @JeriffCheng 都 4202 年了,中国咋可能还不能从 0 训练出来一个大模型呢,gpt 的模型本身就是开源的,一般有几千张卡就能训练个大模型了,很多公司和单位都有这个能力。

|

4

sighforever 2024 年 4 月 23 日 中国的模型总的来说,基础的简单任务还是能胜任的,比如翻译,总结,扩写,代码补全,一般性的聊天都还说的过去,但是稍微复杂一点的推理能力,就差的比较远了,就算是比较好的也一样。

|

5

NXzCH8fP20468ML5 2024 年 4 月 23 日 via Android 今日笑话:国内大模型是 llama 微调出来的。

|

6

Ionian 2024 年 4 月 23 日 说叫“国产”大模型,用的英文语料,copy 的西方开源模型,你告诉我,为什么要用它

|

7

princelai 2024 年 4 月 23 日 一楼那位,但凡你用 AutoModel, AutoTokenizer 加载过模型,哪怕是 6b,7b,8b 大小的,都能知道国产的模型结构都不一样吧,你就说说 glm 是抄的谁的啊,gpt 和 llama 都是 decoder-only 架构的,glm 是 encoder-decoder 架构的,这怎么抄?

|

8

graetdk 2024 年 4 月 23 日 @JeriffCheng 狭隘了,chatglm 早在 llama 开源之前就出现了,llama 确实帮助了后来模型百花齐放,但并非所有的模型(包括国内模型)都是基于 llama 的,甚至有技术架构完全不一样的 rwkv 等

|

9

JeriffCheng 2024 年 4 月 23 日 @sighforever 刚才去查了一下最新资料,腾讯、字节、百度英伟达 A100 的存量都不超过 2000 枚,阿里要多一些。llama 第一代的训练花了 2000 多块 A100 ,finetune 它只需要 10 几块 A100 ,所以,阿里的千问,有可能是自己从 0 训练出来的,其他厂家的大概率是 finetune 的。最新的 llama 3 训练花费了 24000 个 H100 ,目前显卡限令下,国内凑不够这个数量级的显卡。

|

10

justfindu 2024 年 4 月 23 日 目前我觉得最佳的还是 qwen-max , 比百度的 ERNIE-4.0-8K 好一些. 这些都是用 API 接入的, 但是效果比不了 gpt-4, 有些逻辑上还是差一点, 但是在中文写作和各种公文稿来说还是优于 gpt 的.

|

11

justfindu 2024 年 4 月 23 日

@JeriffCheng #9 其他显卡都没办法训练吗? 其他算力都没办法推理吗?

|

12

LiYanHong 2024 年 4 月 23 日 一堆敏感词算法就决定了这个领域的失败

|

13

JeriffCheng 2024 年 4 月 23 日

@justfindu 训练大模型绝大多数都是用 A100 和 H100 ,其他的很少用,具体为啥我也不清楚,我也不是搞硬件的。

|

14

murmur 2024 年 4 月 23 日 |

15

dokke 2024 年 4 月 23 日

https://claude.ai/ 这家是最好用的

|

16

NXzCH8fP20468ML5 2024 年 4 月 23 日 via Android

@JeriffCheng 你说互联网企业没 2 千张 A100 是认真的吗。

就我所知,就连几家国有银行都有 2 千张卡了。 |

17

pkoukk 2024 年 4 月 23 日

@sighforever #3 请问 GPT 在哪里开源的?

|

18

Azure99 2024 年 4 月 23 日 今日笑话 2:腾讯、字节、百度英伟达 A100 的存量都不超过 2000 枚。🤣"出处": https://new.qq.com/rain/a/20230404A0AO0G00

|

19

JeriffCheng 2024 年 4 月 23 日

@xxfye 这半年应该从黑市里流入一些 A100 了吧。

|

20

chiu 2024 年 4 月 23 日

试下经典问题 “鲁迅为什么殴打周树人”

|

21

NXzCH8fP20468ML5 2024 年 4 月 23 日 via Android

@JeriffCheng 银行早在 A100 发布之初就买了一大堆了,后续搞国产化就收手不买了,哪里还等到制裁和黑市

|

22

flynnlemon 2024 年 4 月 23 日

@Azure99 数据不太准哈

|

23

JeriffCheng 2024 年 4 月 23 日 @xxfye 下单和发货是两回事啊,制裁出来之后,很多单都被砍了,不发货了。真正到手的很少。而且很多银行之类的国企买显卡过来并不是干正事的,就是丢在库房里,应付检查的,或者加价倒卖出去,好像还没有哪个银行或者国企发布什么大模型吧。

|

24

iden 2024 年 4 月 23 日 本帖回复是 V2EX 用户对技术与社会认知真实水平的体现

|

25

SkyEcho 2024 年 4 月 23 日 via iPhone 你可以说国产大模型的逻辑能力不如国外的,但你说几个大厂的大模型是 ft 出来的,只能说明是一知半解,强行装懂

|

26

marquina 2024 年 4 月 23 日 @JeriffCheng [激战大模型,云厂商到底拼什么?]( https://m.thepaper.cn/newsDetail_forward_24447179)

“尤其是字节的顶级显卡最多,A100 和 V100 总数接近 10 万块。阿里巴巴集团也拥有大约 10 万块顶级显卡,这些显卡也是阿里云的底气。” 冷知识,大模型火起来之前,各大厂商就已经出于自身业务需要/客户需要采购了大量显卡;大模型火起来后、美国制裁前,各大厂商也在积极向英伟达下单;美国制裁后,各大厂商还在向英伟达下单未被制裁的型号( A800/H800/L20 等等) |

27

neteroster 2024 年 4 月 23 日 via Android

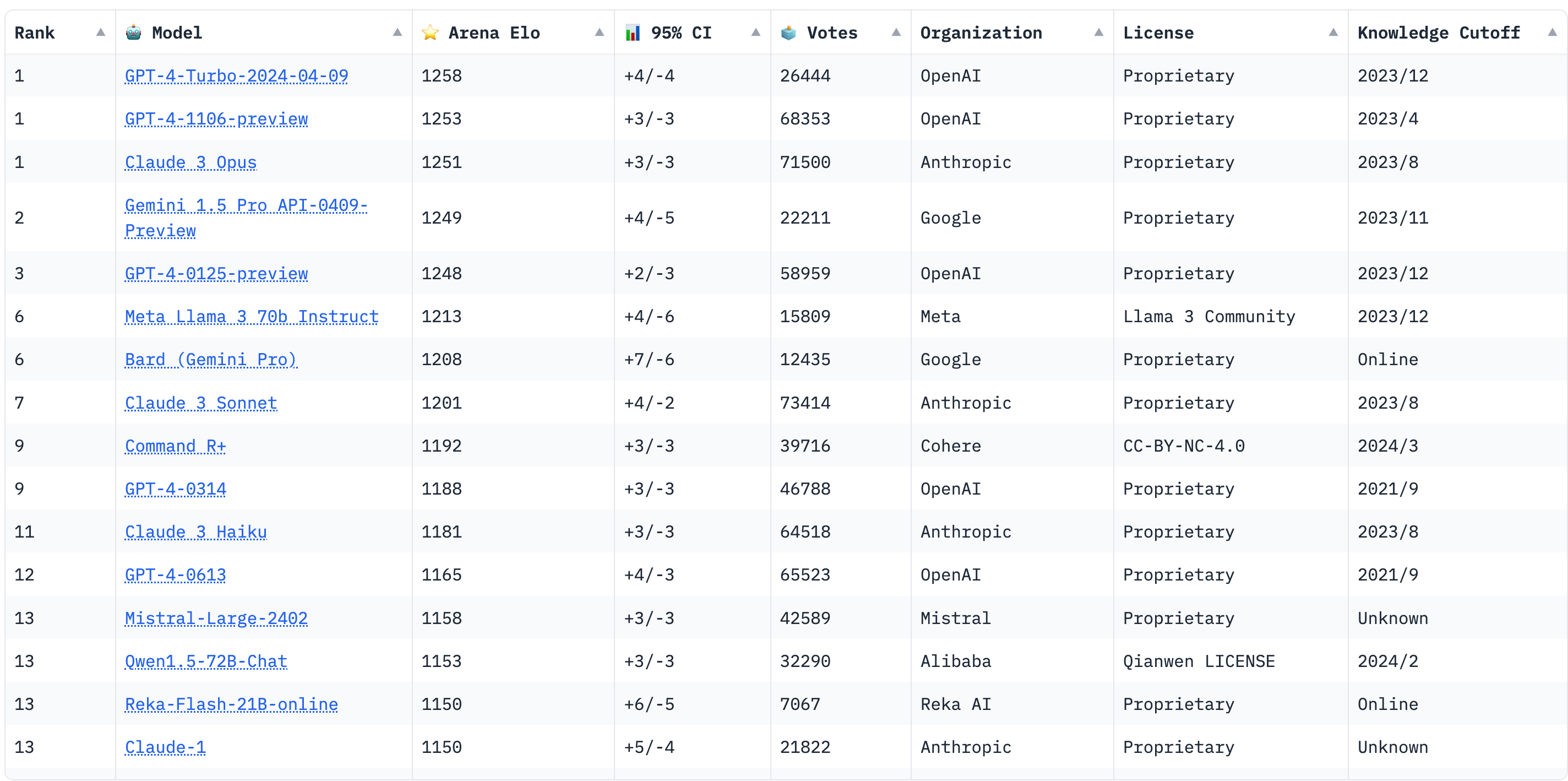

客观来看,国内目前还没有大模型能和 GPT4 Turbo 能力上对位。

不过 OpenAI 现在也就 4Turbo 能拿得出手了,3.5-turbo-0125 烂成什么样子就不多说了,属于是 Chatbot Arena 上要翻好几下才能看到的水平。价格也并不能算得上低。 |

28

NXzCH8fP20468ML5 2024 年 4 月 23 日 via Android

@JeriffCheng 为啥要应付检查丢库房?那不买不就好了。要买还得走长长的采购流程。

银行为啥要发布大模型,银行是讲究效益的地方,连大模型都不想从头训练,都是采购外面的大模型,微调一下就用的。 你以为 A100 除了大模型就没有别的事情可以干么。 |

29

jlkm2010 2024 年 4 月 23 日

qwen-max 确实不错

|

30

marquina 2024 年 4 月 23 日

国内最近发布的第一梯队大模型在跑分上已经接近 gpt4 这样的第一梯队了(至少是 gpt4 的早期版本)。但成本/算力限制了这些大模型的使用范围,而且 gpt4 本身也在不停的演进。

比如:minimax 的 abab6.5 (宣称万亿参数 moe ,gpt4 同等级规模)、天工 3.0 ( 4000 亿参数 moe ) |

31

JeriffCheng 2024 年 4 月 23 日

@xxfye 因为有 ZZ 任务,目标考核,必须拥有多少张显卡。而且也是一门生意,过个把月涨价了就倒卖出去了。(不过最近好像强制买华为的显卡了,买来就丢库房)

|

32

JeriffCheng 2024 年 4 月 23 日

@a302800411 除了显卡算力限制以外,语料同样关键。Finetune 的话,只需要准备少量的针对性的中文预料,比如抖音那个就是不停的问 chatgpt 获得语料。从 0 开始 train ,那需要的语料是海量的。中文互联网高质量语料并不多,大概率训练出来的是一本正经的胡说八道。所以我不大相信国产大模型是自己从 0 开始 train 的。

|

33

goodryb 2024 年 4 月 23 日 模型再大,能力再强,也鉴定不出来前面某些人智商的下限在哪里,一本正经的胡说八道

qwen 应该是目前国内能力最强的一批,之前看有个国际测试排行榜,qwen 是国内唯一上榜的 |

34

Greenm 2024 年 4 月 23 日

@JeriffCheng 你的结论太草率了,喷国内大模型能力不行是没问题的,但是妄下结论纯臆断得出“所有国内大模型中文语料二次训练 finetune ” 是完全错误的。

|

35

2kCS5c0b0ITXE5k2 2024 年 4 月 23 日

是的 所有国内大模型中文语料二次训练 finetune. 我是 qwen 我承认

|

36

NXzCH8fP20468ML5 2024 年 4 月 23 日 via Android

有些人的幻觉比大模型强多了。

也许这就是为什么大模型永远比不过人的原因。 |

37

plp 2024 年 4 月 23 日 via iPhone

先说结论 差远了 国产的连对于中文的语义分析和分词都比不过 用了文言一心 4.0 和 chatgpt4.0 通义千问 我有时候打字快 不加标点符号 语序错乱 错别字 懒得改 有时候话里还夹杂着大量代码 chatgpt 都能通通识别 其他的要不然说: 对不起我还没有这个功能 要不然答非所问 不过国产模型对于一些特定语言 中文的翻译还行

|

38

plp 2024 年 4 月 23 日 via iPhone

当然了 我上面说的 不只是国产模型 还有那个 gemini pro 以及其他国外模型 之类的 也一样 也不知道 chatgpt 怎么做的语义分析 比中国厂商都懂中文…..

|

39

barbery 2024 年 4 月 23 日

国产的大模型优势在于长上下文,非常擅长于长文档类的任务,缺点是通用能力和 gpt4 比还是差一点。。。评论里最让我震惊的是,居然有人认为国产大模型是用开源来 finetune 的。。。

|

40

mohyz 2024 年 4 月 23 日 ...这哥们已经逻辑自洽了,真离谱

|

41

NCZkevin 2024 年 4 月 23 日

@JeriffCheng #9 不懂就别乱说,国内有 1W+ A100 卡的厂商至少有 5 家。事实上 23 年国内厂商还购买了大量的 A800orH800 机器,前几的大厂大模型都是自己训练的。只有小厂才用 llama 微调

|

42

siriussilen 2024 年 4 月 23 日

@sighforever 问题的关键字在于效果吧,“基础的简单任务还是能胜任的,比如翻译,总结,扩写,代码补全” 这些在过去几年,非 decoder only 架构的模型同样也做的很好。 如果没有推理能力就无法胜任更复杂的任务,就不会引发新一轮的生产力变革。

|

43

d119 2024 年 4 月 23 日

看了 1 楼的发言,瞬间觉得美帝制裁的效果真强……但是只要用脚趾头想想,9 楼的那种数字资料就不可能是对的

|

44

trungdieu031 2024 年 4 月 23 日 同等参数级别的大模型,尤其是 70B 以上参数的模型,国产模型确实不如 OpenAI 和 llma, 也就在特定的中文问题上表现好点;

楼上有人说拥有上万卡的公司有好几家,大厂以前囤积的卡包括后来从各地高价收购的卡加起来上万也没啥问题,但这些卡在大厂里也是分散在各处,并不是在一个统一调度的集群里,所以能用来训练大模型的也就在千张量级; 有些早期的大厂模型比如百度这些可能不是用 llma 微调的,但国内确实也有很多微调的大模型,由于国产大模型都没怎么开源,所以也很难判断,但从大厂一贯开源节流,“效率优先”的传统来讲,在开源模型上用中文语料库 finetune 似乎也是预料之中的事; 中文语料由于长期思想审查带来的语料质量方面的问题是存在的;所以会有从 chatGPT 这种大模型里生成中文数据来训练的情况出现; 很多排行榜有数据污染的情况,国产大模型很多为了刷榜提升知名度,会做一些面向刷榜的特定优化 |

45

iyaozhen 2024 年 4 月 23 日 @JeriffCheng 我感觉你很多信息错的离谱,我虽然不知道具体数量(非大模型部门),但肯定不是 2000 这个量级

还有你说的 finetune ,你去了解下就知道了,啥是 finetune 我不是做大模型训练的,是做应用层这块,回到楼主的问题,我们内部评测来看,目前中文各家最贵的那个在非推理能力上,基本上都超过 3.5 了,局部项超过 4.0 。整体还是离 4.0 有点距离,但也能望其项背了 |

46

MapleEve 2024 年 4 月 23 日

首先国内下单的 GB00 NVL72 就有十几万台了

其次国内从零训练的大模型确实很差,还不如 llama2 ,而现在那些微调的 llama3 已经开始卷起来了,但是他们既没有技术,也没有好的 SFT, DPO PPO 。 再次,国外所有社交媒体、新闻、出版书籍都是可以花钱购买语料的,而国内任何一家公司都不会出售自己的语料。 |

47

lithiumii 2024 年 4 月 23 日 via Android 去 chatbot arena 看,综合排名里阿里的 Qwen1.5-72B-Chat 还是很强的,略强于 Claude-1 。限定中文的话,还有 Yi-34B-Chat 也还行。限定代码问题的话 DeepSeek 之前口碑也不错,现在排名下去了。

这些差不多都是 3 到 3.5 的水平,但它们都是可以本地运行的开放模型。国内公司卖 API 的模型性能应该会更好一些 |

48

wOuv7i4e7XxsSOR1 2024 年 4 月 23 日

@JeriffCheng 哥们你真是张嘴就来啊

|

49

hellofreckles 2024 年 4 月 23 日

@JeriffCheng qwen 也会出现中英混搭,肯定也是基于一个英文的基座模型搞起来的

|

50

MuhammadWang 2024 年 4 月 23 日

这个 thread 突然让我对 LLM 能赚钱充满了信息,原来错误信息这么普遍,大家对 LLM 这么不了解

|

51

lvye 2024 年 4 月 23 日

|

52

maolon 2024 年 4 月 23 日 via Android

@hellofreckles 这个不是,是因为 qwen 的中文语料只占 15%,当然这也是 qwen 的国际排名比较高的原因,因为语料还是以英语为主。不过 qwen 和 llama 的架构很像且 qwen 的 embeding 做的比 llama 好,有 16 万条,刚出的 llama3 改进了 embedding 也才 13 万

|

53

lvye 2024 年 4 月 23 日

|

54

R18 2024 年 4 月 23 日

一本正经的胡说八道竟然也有人信。这人之前还嘲讽程序员看源码?

|

56

persistz 2024 年 4 月 23 日

hhhh 楼主的回复就和楼主口中的中文大模型一样,一本正经的胡说八道。

|

58

paopjian 2024 年 4 月 23 日 百度的 ERNIE 在小模型的时候确实有点东西,应该是自研的,但是训练预料肯定很多英文,不然也不会在画图的时候把总线画成 bus 公共汽车

|

60

zouywx86 2024 年 4 月 23 日 这真是大开眼界了,2024 年,居然在 V2EX 上,还能看到认知那么幼稚的人。

话说,楼主有对比过 「智谱清言」没?我现在主要用这个,中文能力感觉比千问要强(当然,我对比的是免费的,因为前面的这个也是免费的),代码能力,感觉也勉强能用。 |

61

lstz OP @zouywx86 谢谢 V 友让我了解到这个模型,刚刚试了一下,和 qwen-max 能力不相上下,正好最近要用模型 API 批量重构代码,省了一顿饭钱了 :P

|

62

zhaiduo 2024 年 4 月 23 日

我的理解是不是国内出不了 Transformers 这样的框架,只要语料足够好,再加上合理的调优,好的模型其实不难。

|

63

SantinoSong 2024 年 4 月 23 日

@mohyz #40 笑死,不仅逻辑自洽,还巨能侃,这老哥不去做出租车司机可惜了

|

64

jr55475f112iz2tu 2024 年 4 月 23 日

@pkoukk GPT 1 和 2 都是完全开源的,GPT 3 在 2020 年 9 月份之前也是开源的,自己去 openAI 的 github 找

|

65

yorhaha123 2024 年 4 月 23 日 via Android

一楼也太离谱了,胡扯都能说一大堆,要真是外行还真被唬得一愣一愣的

|

66

romisanic 2024 年 4 月 24 日

|

67

x4gz 2024 年 4 月 24 日

我怀疑 1 楼也是某个大语言模型(滑稽

|

68

lanlanye 2024 年 4 月 24 日

制裁刚出的时候有个阿里高层的专访,我印象里当时说得还算详细,讲了阿里集团下面各有多少 A100 ,其中阿里云最多,但加起来确实也就几千张。考虑到之后过了挺长时间了,这期间黑市流入的,还有购买替代品之类的加起来可能会多一些。

但你们留意一下也能发现如今报道都是“几万张顶级显卡”,至于“顶级”到底指什么就没人知道了。 |

69

wupher 2024 年 4 月 24 日

中国国情

|

70

Jacobson 2024 年 4 月 24 日

就和那种说“国内新能源车全靠特斯拉开放的 300 多项专利才做起来”那波人如出一辙,有几个人真去了解过特斯拉开放的是些什么专利,国内有几家公司用过它的专利?

不知道从哪听来的几手信息,当成自己的观点并笃信不疑,还特么乐此不疲的继续向外传播,生产队的驴都没这么能干 |

71

fuhanfeng 2024 年 4 月 24 日

一楼的回复让我想起了维基百科的“折毛事件”

“2022 年 6 月,中文维基百科编辑者“折毛”伪造 200 多篇古俄罗斯历史相关条目的行为被集中揭露。该系列伪造事件被视作是开源网络史上最大规模的恶作剧之一,并引发了公众对维基百科公信力的质疑。折毛通常基于真实存在的人或事伪造条目,并使用机器翻译理解俄文资料,精心编造细节以填补翻译中的空白。为了让伪造的细节更真实,折毛屡次扩展与以往伪作相关的条目。经调查,折毛的伪造始于 2010 年的清朝历史相关条目,2012 年开始涉及古俄罗斯历史相关条目,内容主要关于中世纪斯拉夫国家间的政治交互。十多年间,折毛冒充“俄罗斯历史学者”的“权威身份”,并注册马甲,得到维基百科社群信任,逃脱审查机制。” https://zh.wikipedia.org/wiki/%E6%8A%98%E6%AF%9B%E4%BA%8B%E4%BB%B6 互联网中本来就有很多“虚假的信息”,包括很多人带节奏,一楼已经跟 GPT 一样,基于这些信息开始逻辑自洽了。 |

72

xingchenxf 2024 年 5 月 11 日

@JeriffCheng 这个数量肯定低估了

|

74

YlxhjP0CEnQO54M5 2024 年 5 月 30 日

妙哉,已 block 智障 1 楼。

|

75

coffeeforhong 2024 年 6 月 17 日

@princelai glm 早就改成 decoder-only 架构了

|